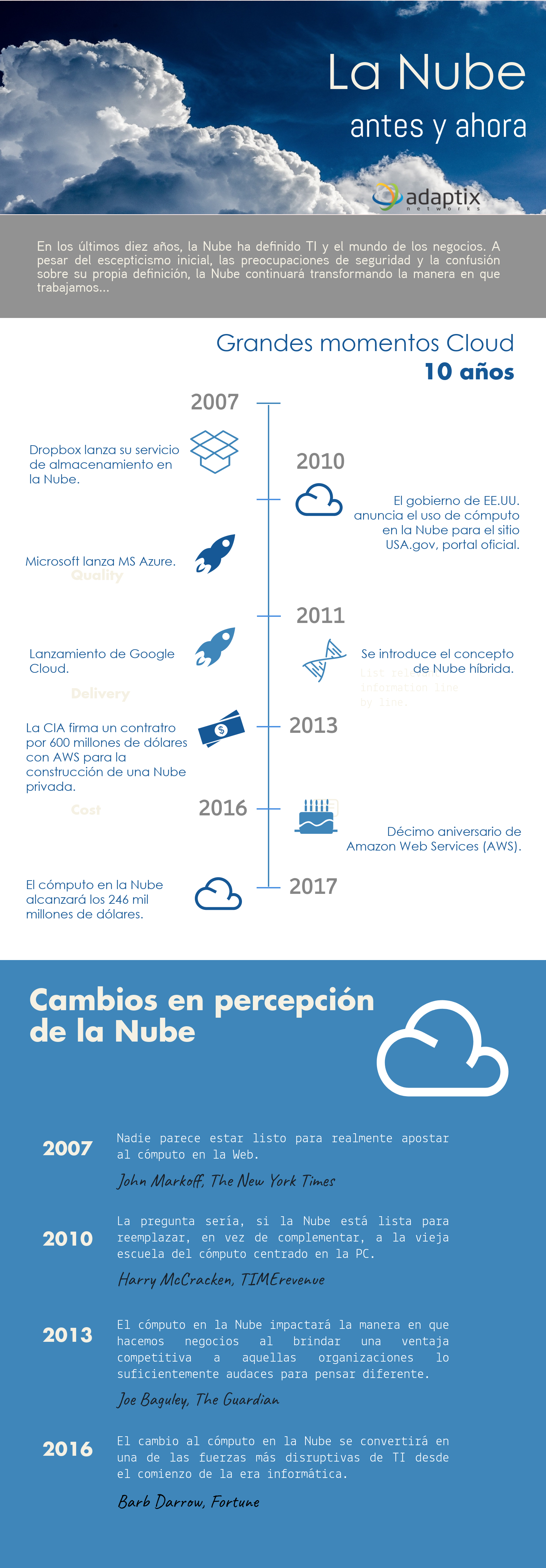

La Nube, antes y ahora

La Nube, antes y ahora. En los últimos diez años, la Nube ha definido el mundo de los negocios. A pesar del escepticismo inicial, las preocupaciones de seguridad y la confusión sobre su propia definición, la Nube continuará transformando la manera en que trabajamos. Grandes momentos Cloud, 10 años.2007, Dropbox lanza su servicio de almacenamiento en la Nube. 2010, el gobierno de EE.UU. anuncia el uso de cómputo en la nube para el sitio usa.gov, portal oficial. Microsoft lanza MS Azure. 2011, Lanzamiento de Google Cloud. Se introduce el concepto de Nube híbrida. 2013, la CIA firma un contrato por 600 millones de dólares con AWS para la construcción de una Nube privada. 2016, décimo aniversario de Amazon Web Services, AWS. 2017, el cómputo en la Nube alcanzará los 246 mil millones de dólares. Cambios en percerción de la Nube. 2007, Nadie parece estar listo para realmente apostar al cómputo en la Nube – John Markoff, The New York Times-. 2010, La pregunta sería, si la Nube está lista para reemplazar en vez de complementar, a la vieja escuela del cómputo centrado en la PC -Harry McCracken, TIMErevenue-. 2013, El cómputo en la Nube impactará la manera en que hacemos negocios al brindar una ventaja competitiva a aquellas organizaciones lo suficicentemente audaces para pensar diferente -Joe Baguley, The Guardian-. 2016, El cambio al cómputo en la Nube se convertirá en una de las fuerzas más disruptivas de TI desde el comienzo de la era informática -Barb Darrow, Fortune-.